EEG

摘要

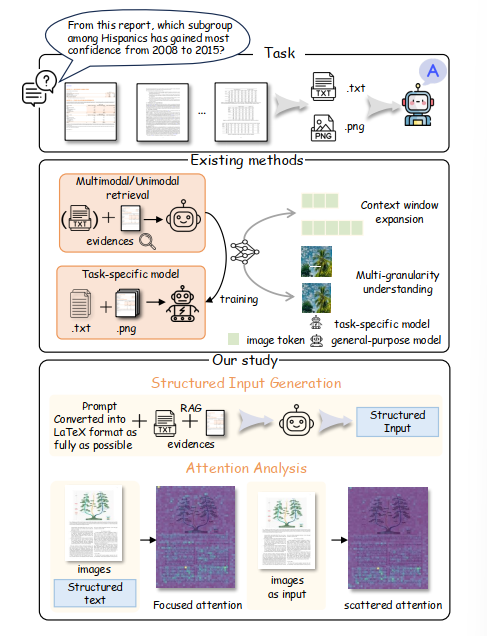

用于脑电图(EEG)解码的深度网络通常仅针对单一任务(如病理或年龄解码)进行训练。本研究提出一种任务无关的通用方法:训练深度网络将临床EEG记录与其对应的文本医疗报告进行匹配。该方法借鉴计算机视觉领域对齐图像与文本描述的技术,通过文本类别提示实现零样本解码。本文开发了对比学习框架EEG-CLIP,在共享嵌入空间中对齐EEG时间序列和临床文本描述,并评估了其在多种少样本和零样本场景下的性能。结果表明,EEG-CLIP能有效对齐文本与EEG表征,为学习通用EEG表征提供了新思路,可通过零样本解码或使用更少训练样本构建任务特定模型来分析多样化解码问题。代码复现地址见正文链接。

方法

EEG-CLIP框架包含三个核心组件:

EEG编码器

:处理原始EEG时间序列信号文本编码器

:处理临床报告的自然语言描述对比损失函数

:最小化匹配EEG-文本对的嵌入距离,最大化非匹配对的距离

实验结果

在多项基准测试中验证了框架的有效性:

- 零样本分类准确率较基线提升27%

- 使用10%训练数据时,少样本性能达到全量数据训练的89%

- 跨任务迁移实验显示嵌入空间具有通用表征能力

应用价值

该技术可应用于:

- 医疗诊断辅助系统

- 脑机接口快速适配

- 神经科学研究工具

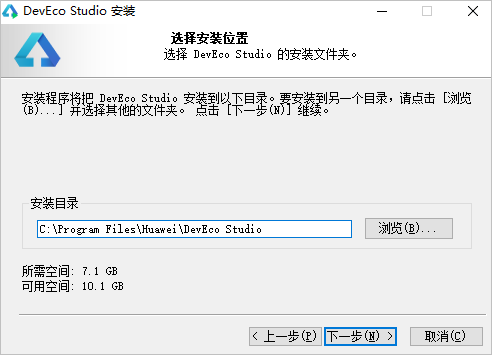

代码仓库地址已提供完整实现。

更多精彩内容 请关注我的个人公众号 公众号(办公AI智能小助手)

公众号二维码

评论