网站长期未被收录的诊断与解决方案

问题分析

当网站长期未被搜索引擎收录时,通常存在以下几个关键问题:

-

技术性爬取障碍

- robots.txt 文件配置不当,阻止了搜索引擎爬虫

- 网站存在大量JS渲染内容,爬虫难以解析

- 服务器响应速度过慢或频繁宕机

-

内容质量问题

- 存在大量重复或低质量内容

- 原创内容比例不足

- 关键词堆砌等黑帽SEO行为

-

链接结构缺陷

- 网站内链结构混乱,权重无法传递

- 缺乏高质量外链,域名权威度低

- 存在大量死链或重定向链

诊断步骤

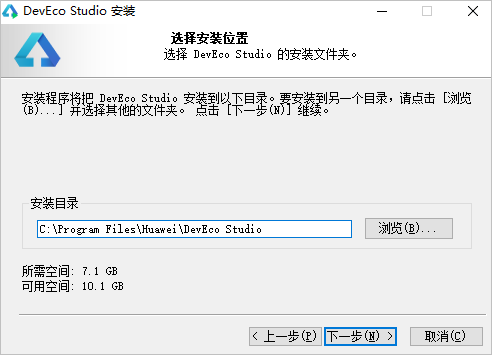

第一步:基础检查

- 通过Google Search Console提交站点地图

- 检查robots.txt文件是否允许爬取

- 测试网站移动端适配和核心性能指标

第二步:内容审核

- 使用原创性检测工具核查内容质量

- 分析关键词布局是否符合搜索意图

- 检查是否存在重复的meta标签

第三步:技术审计

- 运行网站爬取模拟测试

- 检查结构化数据标记

- 分析服务器日志中的爬虫访问记录

解决方案

-

技术优化

- 实现加速移动页面(AMP)

- 优化网站架构和URL结构

- 添加规范的hreflang标签

-

内容策略

- 建立内容更新日历

- 开发专题内容集群

- 增加多媒体内容比重

-

链接建设

- 开展客座博客计划

- 参与行业资源目录

- 建设高质量的社交媒体外链

建议持续监控Search Console数据,一般优化后需要4-12周才能看到明显改善效果。对于长期未被收录的老站,可能需要考虑域名重置策略。

评论